On désigne par Cloud un réseau global de ressources virtualisées accessible par Internet. Plutôt que d’héberger des applications ou de la donnée sur des serveurs physiques privés, des entreprises choisissent de les stocker sur des serveurs externalisés. Basé sur le modèle « Anything as a Service (XaaS) » (tout en tant que service), le Cloud prend toujours plus d’ampleur au sein des entreprises.

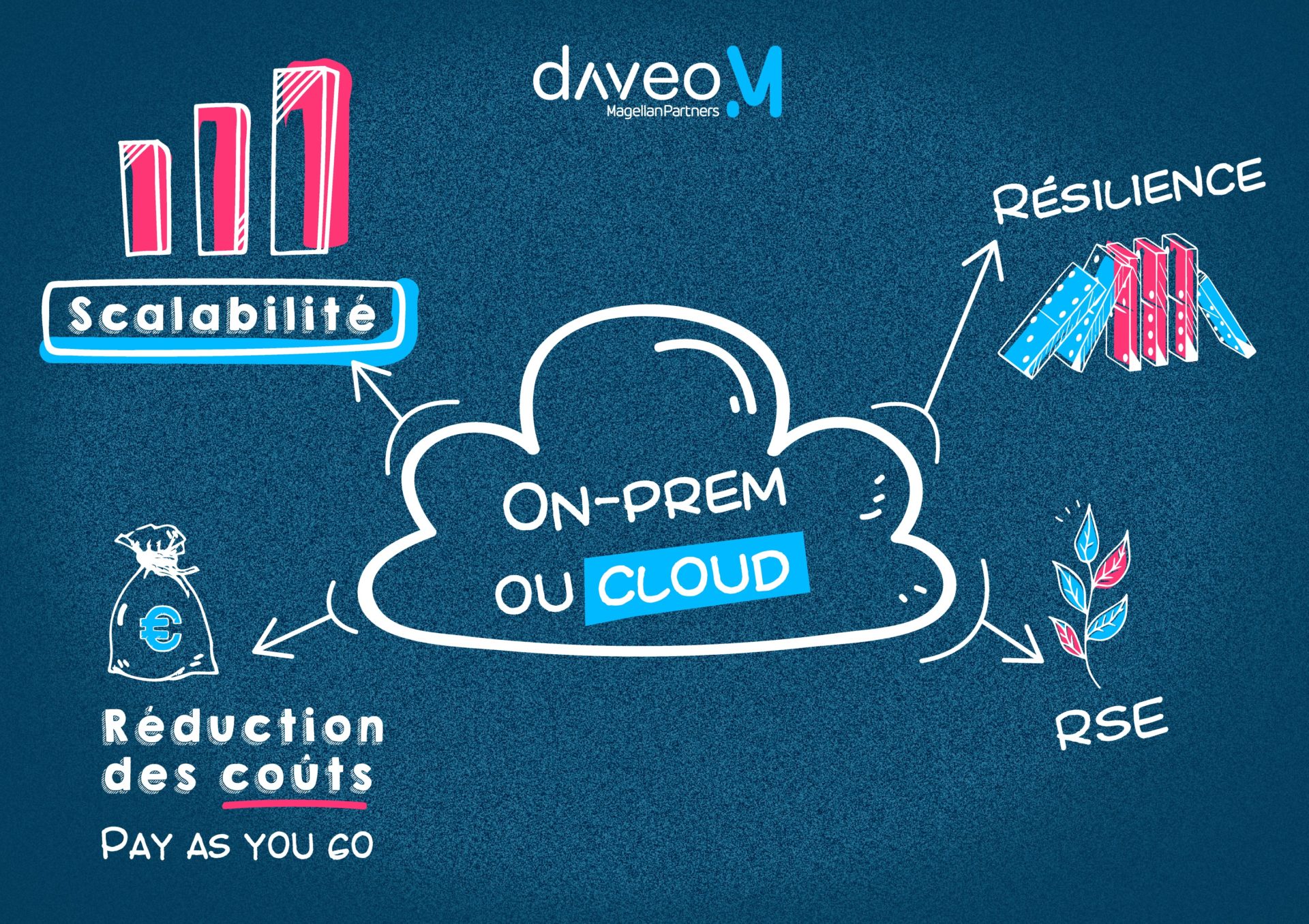

Mais quelles sont les raisons qui poussent les entreprises de toute taille à migrer leur patrimoine applicatif et leurs données sur le Cloud ? Pour répondre à cette question, nous évoquerons les principaux avantages apportés par le Cloud, parfois appelés “piliers du Cloud”.

Comment utiliser l’agilité et la flexibilité du Cloud pour analyser le Big Data ?

Nombreux sont les défis que présente le déploiement d’une infrastructure On-premise (sur site). Entre la définition d’un budget d’investissement pour le matériel, la commande des machines, leur installation et leur configuration, il n’est pas rare que de nombreuses semaines ou mois s’écoulent avant une mise en service. Dans les entreprises disposant d’un SI structuré, l’opération est d’autant plus complexe à mettre en œuvre qu’elle nécessite souvent la participation de plusieurs acteurs ; une équipe infra pour l’installation du matériel, une équipe architecture réseau pour la mise en place des flux, éventuellement une équipe d’exploitation pour intervenir sur l’environnement de production…

Ces difficultés ont été adressées dans le Cloud qui propose, quant à lui, un modèle de déploiement de services automatisés et de services à la demande. Ainsi, un seul individu peut, à partir d’une simple connexion internet, provisionner un nouveau service en une poignée de minutes. Facilitant grandement l’analyse des données, cette agilité dans le provisionnement des ressources devient quasiment essentielle dans la gestion des Big Data (grand volume de données de format varié). Les insights issus de l’analyse des Big Data sur le Cloud permettent aux entreprises de se différencier en optimisant leurs processus, de mieux connaître leurs clients, ou encore d’identifier et de percer de nouveaux marchés.

Quelles sont les erreurs à ne pas commettre sur le cloud ?

De par son mode de fonctionnement, le Cloud transforme profondément les habitudes de développement. Parce que les services sont facilement déployables et que le Cloud pratique une facturation à l’utilisation (Pay as you go). N’importe quel développeur ou architecte peut provisionner des ressources à des fins de test puis les supprimer lorsqu’elles ne sont plus utiles, et ce sans engendrer de surcoût. Vous l’aurez compris “là où la modification est coûteuse et l’erreur punitive sur les systèmes on-premise, la flexibilité du Cloud encourage l’innovation et le refactoring applicatif” commente Thomas, architecte Cloud chez Daveo.

A titre d’exemple, une mise en production critique sera préparée et réalisée bien plus sereinement sur le Cloud. En effet, la flexibilité intrinsèque du Cloud rend possible des méthodes de livraison réversibles et plus sécurisées telles que le déploiement Blue / Green.

Les principaux fournisseurs de services Cloud (CSP) sont implantés mondialement. Leurs infrastructures étant présentes sur tous les continents, toute organisation peut, pour se mettre en conformité ou encore augmenter la résilience de ses applications, copier ou déplacer ses applications dans un centre de données à l’autre bout du monde. Cette large implantation des CSP ouvre de nombreuses opportunités ; que ce soit dans le cadre d’un plan de reprise après incident (Disaster Recovery Plan), pour améliorer les performances d’un service (répliques en lecture seule géographiquement proche des utilisateurs), ou encore dans le cadre d’un déménagement. Obtenir les mêmes résultats avec une infrastructure sur site implique un investissement colossal que peu d’organisations sont disposées à faire.

Le Big Data, le Cloud, et les erreurs de coût irrécupérables

L’agilité permise par les services Cloud permet de rapidement démarrer de nouveaux projets d’analyse de données, mais ce processus accéléré n’est pas sans défaut. Il peut être tentant de diversifier son portefeuille de projets mais le lancement de nouveaux projets, qui implique l’utilisation de nouveaux services et l’emploi d’une main-d’œuvre supplémentaire, se traduit par une explosion des coûts. Il est donc impératif de limiter l’éparpillement des projets en se focalisant sur ceux qui auront le plus de chance d’arriver à maturité.

Comment le Cloud nous aide-t-il à gérer la volumétrie du Big Data?

“Le cloud repose sur la virtualisation et l’automatisation. Il permet aux entreprises de redimensionner de manière transparente leurs équipements et leurs applications” explique Hicham, data engineer chez Daveo. Ceci peut être réalisé sur deux axes :

- La scalabilité verticale réfère à l’ajout de puissance de calcul ou d’espace de stockage sur une infrastructure existante et permet d’accroître les performances d’une ressource unique.

- Dans la scalabilité horizontale, on ne cherche pas à améliorer la puissance des ressources déjà en place mais à ajouter de nouvelles instances afin d’augmenter les capacités en parallèle d’une infrastructure. Cette méthode est également appelée scaling out.

Certaines applications Cloud, dites « élastiques » ou « auto scaling », se redimensionnent automatiquement en fonction de leurs utilisations. Flexibles, ces applications se démarquent par de meilleures performances, une disponibilité de service accrue, tout en réduisant les coûts. En termes de Big Data, la scalabilité est directement liée à la performance. L’une des caractéristiques du Big Data est son importante volumétrie de données en constante augmentation. Plus les données sont volumineuses, plus le besoin en ressources est important. La scalabilité offerte par le Cloud permet d’adapter les systèmes aux problématiques du Big Data. Les ressources peuvent être tout aussi facilement réduites, c’est donc à l’entreprise de trouver un juste milieu.

Peut-on hiérarchiser le Big Data pour économiser à long terme ?

L’auto-scaling permet de réaliser des économies en optimisant l’allocation des ressources mais cela n’est qu’un des leviers permettant de réduire la facture IT grâce au Cloud.

La première source d’économie offerte par le Cloud consiste à effacer l’investissement du capital machine et à le remplacer par un principe « pay-as-you-go », qui signifie que l’on paye à l’utilisation (se référer à la phrase “Pay as you Go” du bloc flexibilité). Pour le fournisseur du Cloud, les économies d’échelle permettent des réductions de prix grâce à l’achat d’infrastructures en grande quantité (ce modèle est rendu possible par les économies de volume réalisées par le cloud provider).

Économie ressource humaine

Le Cloud permet également de réaliser des économies sur la maintenance du socle applicatif et sur la sécurité (services administrés). En utilisant les services administrés du Cloud, le déploiement de solutions diverses nécessite moins d’expertise, il n’est ainsi plus nécessaire de faire appel à une main d’œuvre coûteuse ou de spécialiser les employés. Le fournisseur fait en sorte que les applications fonctionnent les unes avec les autres et cela évite les frais généraux de l’entreprise avec un data center sur site (uniformisation, inter connectivité). En termes de sécurité, seule la partie applicative est sous la responsabilité du client, l’infrastructure physique et la virtualisation étant prise en charge par le fournisseur de Cloud. Cette réduction de périmètre permet au client de se concentrer sur son cœur de métier.

Uniformisation

Pour leurs applications On-premise, bon nombre d’entreprises disposent d’interfaces d’administration disparates. Celles-ci, plus ou moins complexes, sont souvent gérées par différentes équipes. On imagine par exemple une équipe socle Linux ayant une visibilité sur une partie du parc, une équipe socle Windows chargée de surveiller un autre périmètre et ainsi de suite. Cet éparpillement des équipes et des interfaces ne peut qu’entraîner des retards, et l’uniformité permet d’éviter tous ces obstacles. L’uniformisation nous permet aussi de suivre la hiérarchie des besoins en matière de Data Science (graphique ci-dessous) pour évaluer le Big Data. S’il y a une cassure dans la hiérarchie, il est très difficile de pouvoir analyser la data. Avec le Cloud les cassures sont inexistantes. Par conséquent, la data est prête à être consommée et analysée.

La résilience est-elle importante pour la collecte de données du Big Data?

La résilience applicative est la capacité d’un système à assurer une continuité de service face aux incidents ou à une forte utilisation. Sur le Cloud, elle est garantie par la redondance des services dans différentes zones géographiques. Cette redondance permet, en cas de panne d’électricité, catastrophe climatique, ou autres soucis qui peuvent impacter un data center, la continuité du fonctionnement de l’application grâce à un autre data center. Cela permet d’éviter la rupture (discontinuité) de service ainsi que la perte de données. En termes de Big Data la résilience a un impact très simple : plus le mode de recueil est stable, plus on peut recueillir de données qui pourront être utilisées et analysées.

Enfin, le Cloud présente des atouts qui permettent aux entreprises d’améliorer leur bilan RSE. Pendant la pandémie COVID-19, les entreprises déjà sur le Cloud ont mieux su préserver leur masse salariale ; les collaborateurs de ces sociétés ont pu poursuivre leur travail avec peu d’interruption. De manière générale, les entreprises utilisant des services Cloud ont mieux géré le télétravail imposé et la mise en place d’un Plan de Continuité d’Activité (PCA) y a été plus aisée.

Le recours aux services Cloud réduit également le besoin des entreprises en matériels informatiques, tel que les serveurs. L’entretien de l’infrastructure physique étant délégué au fournisseur Cloud, l’achat de nouvelles ressources se voit limité aux ordinateurs de bureau. La concentration des ressources informatiques dans les data centers de grands Cloud providers engendre moins de pollution. Cela s’explique par le fait que l’équipement des centres de données soit généralement plus pérenne que celui des entreprises, limitant de fait la production de nouvelles machines. Virtualisées à la demande, les ressources des centres de données sont souvent mieux utilisées et de nombreuses optimisations ont permis à ces bâtiments de réduire leur consommation énergétique.

Quel avenir pour le Cloud et les entreprises ?

L’adoption du cloud augmente chaque année car les entreprises reconnaissent vite ses avantages sur leur sécurité, leurs collaborateurs, leur production et leurs revenus. En utilisant une solution cloud, une entreprise peut éviter de nombreux problèmes qui affecteraient une infrastructure On-Premise. Cela dit, le cloud n’est pas une solution à tous les problèmes, mais plus la technologie cloud évolue, plus elle résout les problématiques pour les entreprises.